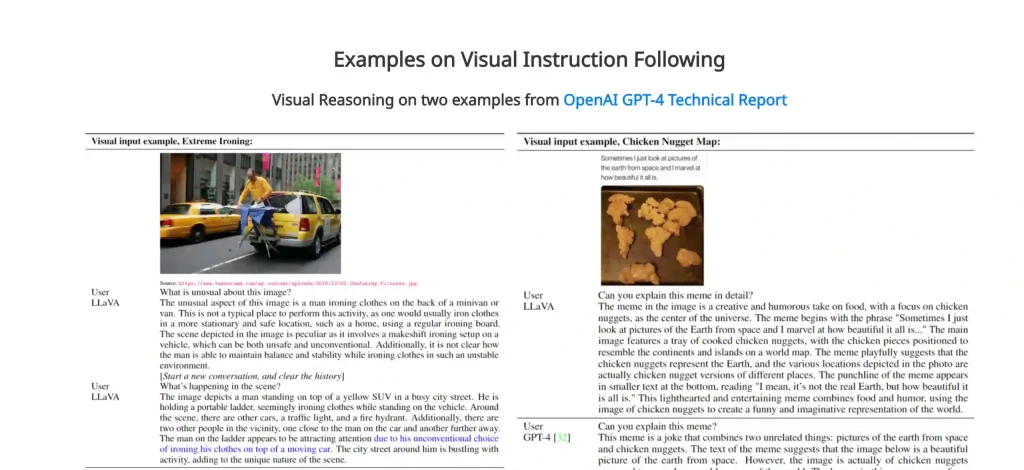

¿Qué es LLaVa? LLaVA es un modelo de lenguaje multimodal, entrenado de principio a fin, que combina un codificador de visión con Vicuna, para entender de forma general el lenguaje y lo visual.

LLaVa logra una excepcional capacidad para el chat, imitando la esencia del multimodal GPT-4 y estableciendo nuevas mejoras. Sus creadores prometen ser un modelo muy preciso en una materia en concreto, en la solicitud de preguntas y respuestas sobre ciencia.

Características del modelo LLaVA

Multimodal Instruct Data: utilización de GPT-4 para generar datos de seguimiento de instrucciones de imagen de lenguaje multimodal.

Modelo LLaVA: modelo multimodal entrenado de extremo a extremo que conecta un codificador de visión y un LLM para la comprensión visual y del lenguaje de uso general.

Performance: altas capacidades de chat multimodal que cuando se ajusta a preguntas-respuestas sobre Ciencia, la sinergia de LLaVA y GPT-4 logra una precisión cercana al 92,53%.

Open Source: se encuentran a disposición del público todos los datos de ajuste de instrucciones visuales generados por GPT-4, el modelo y la base de código.

Si quieres conocer todas sus funcionlidades puedes dirigirte a las siguiente páginas:

Para seguir la actualidad de las noticias más interesantes sobre robótica colaborativa e inteligencia artificial, no dudes en visitar nuestras Últimas noticias.

Abogada especializada en Inteligencia Artificial Generativa, LLMS y ética de la IA. Participa en la elaboración del Código de Buenas Prácticas de la Comisión Europea y la Oficina Europea de IA, que regulará el uso de modelos de IA de propósito general en la UE. Miembro de OdiseIA en el área robots-persona.